A chamada Lei de Moore assevera que o número de componentes em um circuito integrado dobra a cada dois anos. Obviamente não é uma lei da natureza, mas questões nomotéticas à parte, essa tendência vem se observando na micro(agora, nano)eletrônica há 50 anos. A “lei” recebe o nome de seu proponente, Gordon Moore, cofundador da Intel, que em um artigo escrito em 1965 profetizou o ritmo da crescente complexificação e miniaturização dessas pastilhas pretas que hoje encontram abrigo até nas geladeiras. Esse comportamento só é possível com o advento de sucessivos “fatores facilitadores”, ou seja, pequenos passos ou saltos tecnológicos, que permitem aumentar o número de componentes em um mesmo centímetro quadrado. Para quem não conhece ainda a Lei de Moore, começar pela Wikipédia é uma boa dica [I].

A chamada Lei de Moore assevera que o número de componentes em um circuito integrado dobra a cada dois anos. Obviamente não é uma lei da natureza, mas questões nomotéticas à parte, essa tendência vem se observando na micro(agora, nano)eletrônica há 50 anos. A “lei” recebe o nome de seu proponente, Gordon Moore, cofundador da Intel, que em um artigo escrito em 1965 profetizou o ritmo da crescente complexificação e miniaturização dessas pastilhas pretas que hoje encontram abrigo até nas geladeiras. Esse comportamento só é possível com o advento de sucessivos “fatores facilitadores”, ou seja, pequenos passos ou saltos tecnológicos, que permitem aumentar o número de componentes em um mesmo centímetro quadrado. Para quem não conhece ainda a Lei de Moore, começar pela Wikipédia é uma boa dica [I].

A pergunta do título propõe a reflexão se existiria uma Lei de Moore para a publicação científica. Derek Solla Price chegou a sugerir que a publicação científica cresce exponencialmente em determinados períodos em seu artigo “Medidas quantitativas do desenvolvimento científico" [II], que é de 1951. Solla Price baseou-se em dados passados para tentar extrapolar o futuro, já Gordon Moore sugeriu sua antevisão ainda no nascedouro de seu objeto de estudo. Contar transistores em um circuito integrado é um problema técnico, conseguir contabilizar o número de artigos científicos publicados já é bem mais difícil. A lista de perguntas é enorme. O que pode ser considerado um artigo científico? Como desenvolver uma ferramenta de busca desses artigos, supondo que informações sobre todos sejam acessíveis pela web? Mesmo que essa busca seja possível, como estruturar os dados para que uma “lei de crescimento” possa ser verificada? Hoje a ferramenta Google Acadêmico parece dar conta de um busca abrangente, mas não da última pergunta.

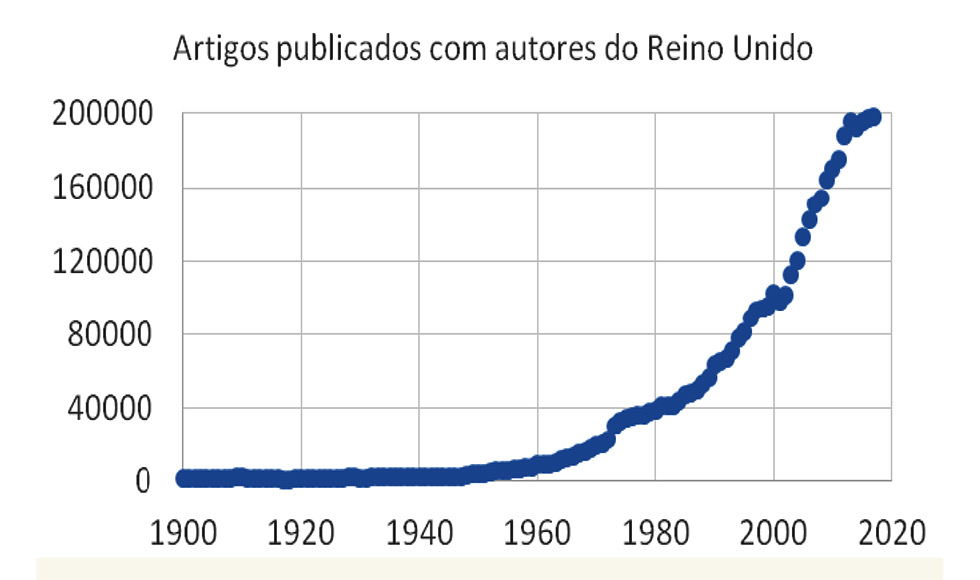

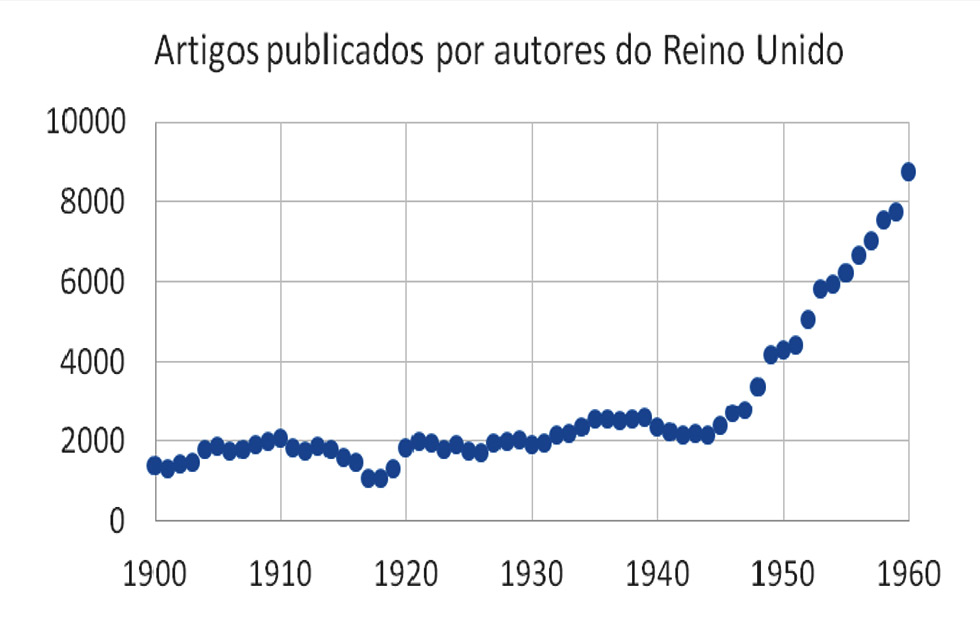

Além disso, podemos acrescentar outra questão, se, por um lado, transistores são transistores, por outro lado existem periódicos e periódicos, bem como artigos e artigos. O que é possível fazer então é lançar mão de um recorte de dados: construir uma série histórica de artigos publicados em revistas indexadas em uma base de dados seletiva. As bases de dados, no entanto, são crescentemente imprecisas quando nos afastamos no tempo: apresentam lacunas e saltos, que são difíceis de correlacionar com fatores outros que não problemas internos às bases. A primeira figura que ilustra esta coluna é uma série histórica de número de artigos com autores do Reino Unido indexados na base Scopus. É um exemplo que superou os testes simples de consistência e por isso mesmo é apresentada aqui. Podemos arbitrariamente dividir a figura em dois períodos, de 1960 para frente, em que o número de artigos parece crescer exponencialmente ano a ano (é rápido, mas não chega a ser exponencialmente) e o período anterior, de 1900 a 1960. Esse período anterior merece uma lupa, que é a figura seguinte. O que se observa é um crescimento bem menos acentuado com depressões na produção de artigos durante as duas guerras mundiais, como esperado, e logo depois da segunda dessas guerras o aumento de publicações parece irrefreável, sugerindo uma possível lei de Moore para artigos científicos e não transistores, mas e daí? O que nos diz isso?

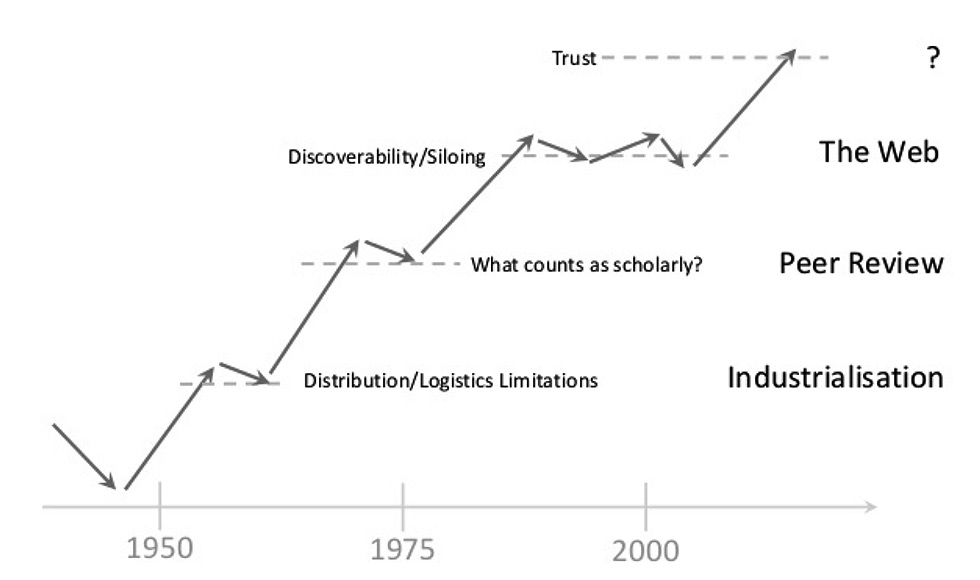

O interessante na Lei de Moore é a sucessão de “fatores facilitadores” que a mantém ao longo das décadas, os passos e saltos tecnológicos já aventados acima. Quais seriam os facilitadores para a publicação científica? E ao identificá-los poderíamos sugerir que no caso dos artigos a lei chamasse “lei de Neylon”. Cameron Neylon é um biofísico australiano que virou professor de comunicação de pesquisa e defensor do acesso aberto. Em uma palestra no 6º Encontro Brasileiro de Bibliometria e Cientometria ele apresentou o gráfico esquemático que reproduzo abaixo [III]. As linhas ilustram a produção científica publicada ao longo do tempo. Os degraus são atingidos quando se alcançam o que ele nomeia de limites intrínsecos para a expansão, que são superados pela adoção do que ele chama de inovação endógena (ou seja, dentro do próprio sistema de produção científica) e a coisa volta a crescer. Sou tentado a enxergar uma correspondência entre os degraus dessas inovações endógenas e os pequennos “acidentes” na primeira figura que eu gerei. Como isso é uma coluna e não um artigo científico, posso me contentar apenas com essa sugestão de correspondência, sem verificá-la à exaustão. Essas “inovações endógenas” seriam os “fatores facilitadores” para a manutenção da “lei de Neylon”

Uma vez derrotado o Eixo e iniciada a Guerra Fria, como se comportou a publicação científica? Os periódicos tradicionais da época expandiram o número de artigos publicados, que rapidamente chegou ao limite logístico e de distribuição. A inovação encontrada foi a industrialização da publicação científica, ou seja, a entrada em cena dos grandes grupos editoriais, que, de fato, expandiram o sistema, mas à custa de práticas predatórias típicas dos novos magnatas editoriais, perto dos quais o cidadão Kane de Orson Welles pareceria um coroinha [IV]. Esse novo modelo de negócios também encontraria seu limite e a próxima etapa foi introduzir a revisão por pares, conhecida internacionalmente por peer-review. É isso mesmo, “a revisão por pares não é tão antiga quanto você poderia pensar” [V]. Acostumamo-nos a pensar que esse tipo de avaliação é o divisor entre artigos científicos e os outros, um controle de qualidade, mas foi na verdade, segundo Neylon, uma inovação endógena para continuar aumentando o número de artigos publicados. Avaliação de artigos é, de fato, antiga, mas a generalização da conduta do editor delegar a um par a revisão e, na prática, a decisão editorial é bem mais recente. Segundo o Oxford English Dictionary, a expressão peer review passou a ser usada para designar o processo de avaliação de artigos apenas em 1967. A história é longa e complicada e vale a pena ler o artigo nomeado acima e publicado no Times Higher Education. O resumo é que, até meados do século passado, a ação do editor ou comitê editorial era bem mais importante, revisando a revisão dos pares.

Ao juntar as peças desse quebra-cabeça, lembro-me de experiências pessoais com peer reviewers. Quando comecei minha carreira (o Brasil nem tetra campeão era), os revisores apontavam falhas e davam dicas. Uma vez um revisor recusou um artigo meu, descrevendo-o como irrelevante. Eu respondi dizendo que ele não havia entendido. O editor acolheu minha resposta e passou-a ao revisor que respondeu pedindo desculpas, dizendo que ele se equivocara e que o artigo deveria ser publicado. Há pouco mais de um ano aconteceu o mesmo, o parecer denunciava que o seu autor não entendera o meu trabalho. Escrevi uma resposta e o editor da revista respondeu dizendo que o artigo estava recusado e que a diretriz editorial era de não fomentar “debates” entre autor e revisor. Advertência de Neylon: revisão por pares tem a ver com quantidade e não qualidade. A linha fina do artigo no Times Higher Education alerta: “revisão por pares não deve ser tratada como vaca sagrada”. A experiência que eu narrei parece concordar com o aviso de Neylon e o conselho de não sacralizar o processo que se transformou, pois “debates” entre revisores e autores reduzem o ritmo de publicação. A “lentidão” do processo (mesmo sem “debates”) fez emergir a revisão “fast-track” para publicar rapidamente o que seria de interesse imediato: publica-se em até 72 horas, mas com a mesma qualidade na revisão. Alega-se. Sobre isso recomendo o excelente artigo de Carolina Medeiros no Dossiê “Ritmos do Conhecimento” da revista ComCiência [VI].

Próximo salto: a Web, que, por um lado, permitiu o acesso aberto, mas, por outro, trouxe as revistas predatórias [IV]. Qual é o limite intrínseco que a inovação endógena advinda com a Web e as revistas on-line ajudou a superar (para continuar a expandir o sistema)? A expansão do número de periódicos e a crescente especialização dos mesmos levaram ao ensilamento (siloing) e à dificuldade de rastreamento (discoverability) do conhecimento. A nova questão agora, no entanto, como colocada no singelo slide reproduzido acima, é exatamente essa: confiança? (trust?). Neylon na sua palestra alertou que os muitos acadêmicos que se queixam sobre como lidar com a internet deveriam lembrar que seu uso da forma como está sendo usada foi promovida pela própria comunidade científica.

Buscando referências encontrei outras palestras desse cientista com renome na área e índice h de respeito. Os títulos são interessantes: “Excelência é bobagem (bullshit)” e “Excelência é uma agenda neocolonial...e o que podemos fazer a respeito”. Isso fica para uma outra vez, por hoje é só.

[I] https://en.wikipedia.org/wiki/Moore%27s_law

[II] http://garfield.library.upenn.edu/price/pricequantitativemeasures1951.pdf

[III] A figura em si eu extrai de outra apresentação compartilhada pelo autor, chamada “Beyond Open”

[IV] https://www.unicamp.br/unicamp/ju/artigos/peter-schulz/o-ethos-e-seus-predadores

[V] https://www.timeshighereducation.com/features/peer-review-not-old-you-might-think

[VI] http://www.comciencia.br/fast-tracking-rapidez-para-levar-conhecimento-cientifico-a-publico/