Os rankings vieram para ficar. Esta é uma das constatações de um relatório da Associação Europeia de Universidades de 2011, quando haviam decorridos oito anos do lançamento do primeiro desses rankings globais de universidades. Hoje, sete anos depois deste relatório, a constatação se confirma e se amplia: rankings transformaram-se em um fenômeno cultural, permeando o cotidiano das universidades, de seus stakeholders e da imprensa; apenas no último mês, versões atualizadas de vários deles foram anunciadas. Já escrevi sobre rankings, mas o enfoque aqui será outro: entendê-los melhor e depois, com os próprios, aprender algo mais sobre as universidades.

Os rankings vieram para ficar. Esta é uma das constatações de um relatório da Associação Europeia de Universidades de 2011, quando haviam decorridos oito anos do lançamento do primeiro desses rankings globais de universidades. Hoje, sete anos depois deste relatório, a constatação se confirma e se amplia: rankings transformaram-se em um fenômeno cultural, permeando o cotidiano das universidades, de seus stakeholders e da imprensa; apenas no último mês, versões atualizadas de vários deles foram anunciadas. Já escrevi sobre rankings, mas o enfoque aqui será outro: entendê-los melhor e depois, com os próprios, aprender algo mais sobre as universidades.

O pioneiro dos rankings é chinês (Academic Ranking of World Universities, o famoso ranking da Universidade Shanghai Jiao Tong), lançado em 2003 com o propósito alegado de ser um guia para estudantes chineses buscarem as melhores universidades no exterior e, ao mesmo tempo, um parâmetro para as universidades chinesas. Era global, classificando universidades de todo o mundo, considerando todas as áreas do conhecimento, cujos indicadores eram baseados em dados secundários (coletados de outras fontes). Hoje temos rankings com origens em diferentes países, da Inglaterra aos Emirados Árabes Unidos, globais ou regionais, específicos por áreas do conhecimento, com diferentes metodologias, enfocando distintos aspectos, usando indicadores a partir de dados primários (coletados exclusivamente) e secundários (para múltiplos propósitos e apropriados por esse ou aquele ranking). Um fenômeno cultural, mas também comercial com os fornecedores dos rankings oferecendo análises personalizadas, que são obviamente pagas.

É preciso lembrar que estamos acostumados a rankings a ponto de naturalizá-los. Algumas dessas classificações são simples. Em uma competição esportiva leva a medalha de ouro quem correr mais rápido, saltar mais alto ou arremessar mais longe. Já o ranking olímpico é um pouco mais complicado. O Comitê Olímpico Internacional, COI, assevera que a classificação é por número de medalhas de ouro conquistadas nas dezenas (centenas?) de modalidades. Parece inquestionável e sempre seguido à risca pelos EUA, promotores de uma cultura competitiva descrita pelo bordão “você não conquistou a prata, e sim perdeu o ouro”. Isso até os Jogos Olímpicos de Beijing, quando os chineses conquistaram mais medalhas de ouro do que os estadunidenses. Mas o número total de medalhas norte-americanas foi maior e a imprensa de Washington a Los Angeles passou a dar valor às medalhas de prata e bronze para colocar o país das “estrelas e listras” de volta no topo.

Classificar universidades é bem mais complexo. Quais seriam as “modalidades esportivas” (indicadores) escolhidas? E como juntar esses indicadores para obter uma classificação: cada “medalha” teria o mesmo peso na soma, como no caso do ranking do COI? Podemos então simular a proposta de um ranking. Existem dois caminhos. O primeiro deles é o de inicialmente discutir as “ideias de universidades” ou as “universidades necessárias”, para parafrasear títulos de obras de autores que discutiram a questão. As universidades, não os rankings. Após uma conclusão (se possível) seguiria a construção de uma medida para essa síntese. Um segundo caminho seria mais pragmático: simplesmente olhar as universidades para as quais já existe uma percepção prévia, intuitiva e qualitativa, de quais são as melhores e verificar que indicadores quantitativos confirmariam essa percepção. Antes dos rankings globais de universidades, Harvard, MIT, Cambridge e Oxford, entre algumas outras, já eram consideradas as melhores. E nos rankings assim criados seguiriam as demais. Deixo para o leitor ponderar qual simulação aproximar-se-ia mais à proposta do primeiro ranking. Como já mencionado, o ARWU foi lançado em 2003 e seus seis indicadores eram voltados exclusivamente à pesquisa, tanto para os resultados (número de artigos em revistas de altíssimo impacto e em outras revistas indexadas), quanto de prestígio (número de docentes altamente citados ou recipientes de prêmio Nobel, além de ex-alunos detentores dessa honraria). Rankings subsequentes incorporaram outras medidas, contemplando (mais ou menos) as outras missões de uma universidade. Para uma discussão introdutória das metodologias dos rankings, suas limitações e cuidados de interpretação, pode-se ler o capítulo de Justin Axel-Berg (“Indicadores para Efeito de Comparação Internacional no Ensino Superior Brasileiro”) do livro “Repensar a Universidade”.

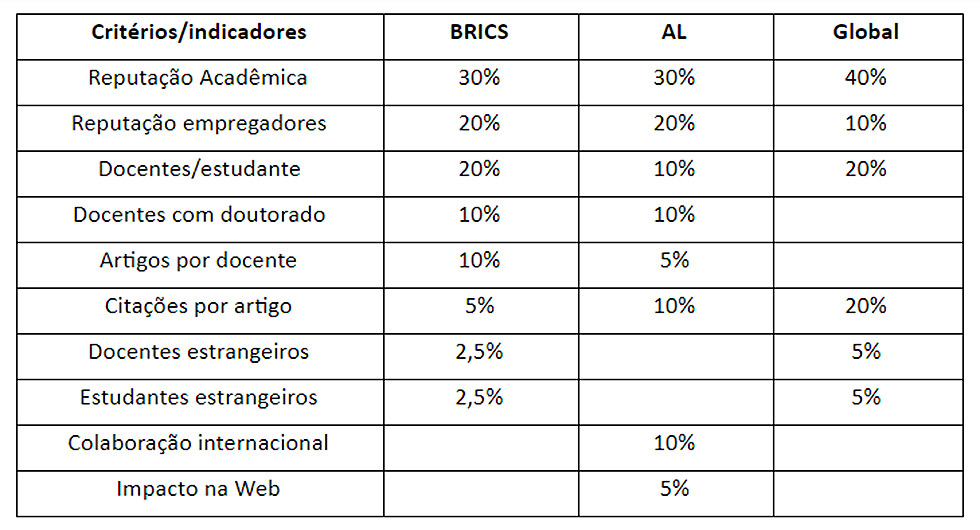

O formato atual das páginas Web dos diversos rankings permite a cada navegador dessa rede vasculhar por conta própria os meandros dessas classificações e suas metodologias. É o exercício a que me propus em um estudo de caso de um dos (pelo menos) seis rankings anunciados no último mês. Trata-se do QS World University Rankings para universidades nos países que formam o BRICS, edição 2019. Ao acessar essa página, a imagem da tela que surge é reproduzida na ilustração (abaixo) que acompanha este texto, na qual são destacados 4 ícones. Ao clicar em “1” aparece o cardápio de produtos da plataforma QS e, ao pressionar em “2”, descortina-se a metodologia, ou seja, os critérios que compõem a classificação. A tabela que também acompanha este texto apresenta o quadro desses critérios, junto com o quadro para o ranking mundial geral e o para a América Latina (AL).

Os nomes dos critérios/indicadores são autoexplicativos, mas mesmo assim uma breve descrição se faz necessária. Em primeiro lugar, os indicadores de reputação são obtidos por meio de pesquisas (surveys) entre pares acadêmicos e empregadores de egressos de universidades. Os outros indicadores são de dados secundários, extraídos dos anuários das universidades ou de bases de dados bibliográficas (artigos e citações) ou ainda de outros rankings (impacto na Web: http://www.webometrics.info/en ).

A tabela merece várias observações. A primeira delas é que o conjunto de critérios para o ranking global traduz uma visão de universidade, que não é a única, mas sim a dos stakeholders do ranking. Em segundo lugar, notamos que metade da nota é por reputação (percepção) de cada universidade e apenas a outra metade é devido aos indicadores quantitativos. E uma pergunta surge: qual é a relação entre os indicadores (e sua promoção por políticas de pesquisa/avaliação) e as reputações? Chama a atenção também o critério de docentes por estudante, que traz a mesma informação do indicador discentes/docente, que é a mais utilizada por aqui. Um exercício rasteiro de análise do discurso sugere que a primeira versão parece se preocupar com o que a universidade oferece para os estudantes, enquanto a segunda está mais relacionada com a carga de trabalho do docente e o custo da universidade.

Uma observação adicional é de que os critérios para as classificações por região (aqui BRICS e AL) têm pesos diferentes, além de inclusão de novos indicadores. Isso parece indicar que, na visão do QS, universidades em regiões diferentes têm características, funções e necessidades diferentes. Mas quais funções e necessidades? Dentro de uma perspectiva de que o objetivo (novamente: do ponto de vista do ranking em questão) de cada universidade seria subir sua classificação geral, os critérios adicionais podem ser interpretados como uma “dica” do que dever ser feito.

Enveredando perigosamente para o terreno das opiniões rápidas, vemos que a visão promovida pelo QS é a de que obviamente todos os docentes de uma boa universidade devem ser doutores. Esse critério, portanto, não está incluído na classificação global, mas está lá para AL e BRICS. De fato, poucas universidades no Brasil têm quadros docentes com 100% de doutores. Quer subir no ranking global? Qualifique os docentes, é isso que o ranking recomenda. Um problema sério para as universidades privadas com fins lucrativos (que, aliás, não aparecem nesse ranking), preocupadas em reduzir custos de acordo com o que permite a flexível legislação brasileira referente ao assunto.

Outra recomendação latente no ranking para os BRICS e AL seria: publiquem mais, publicação intensa é tacitamente entendida também como uma pré-condição natural para estar bem classificada mundialmente. Outra recomendação: internacionalizem-se, mas de formas diferentes; para o BRICS, aumentar o número de estudantes e docentes estrangeiros seria recompensado no ranking, enquanto que para a AL apenas a colaboração internacional em pesquisa seria o caminho a ser incentivado. De novo existe a percepção de que esses critérios se alinham com o peso de políticas locais e regionais de internacionalização, estratégia assumida como a saída para melhorar a qualidade do ensino e pesquisa. De qualquer forma, colaboração internacional no plano global é tomada como algo óbvio e natural, mas o interesse em atrair estudantes e pesquisadores estrangeiros é, por outro lado, valorizado (não se esqueçam de ver a tabela).

Como última observação, uma curiosidade: por que apenas para a AL o impacto na Web é um critério? Diz a metodologia do ranking: “esse indicador busca avaliar a efetividade com a qual as instituições utilizam novas tecnologias”. Será que se, por um lado, uma universidade não sobe no ranking pela baixa qualificação dos professores ou um número elevado de estudantes por docente, por outro lado pode compensar com ensino à distância? Pelo menos no ranking regional, que talvez seja o que interessa para questões de mercado.

Resumindo até aqui: se em um artigo anterior eu chamo a atenção para a interpretação pura e simples das classificações, agora eu sugiro uma discussão dos critérios em si. Assim aprendemos sobre os rankings, mas o que podemos compreender com eles? Se clicarmos no ícone “3” da figura para cada universidade, visualizaremos uma breve descrição da mesma e os dados para os indicadores considerados para o ranking global. Uma clicada no ícone “4” apresenta os indicadores para os rankings regionais (BRICS ou AL), mas a disposição é um pouco confusa para realizar a proposta a seguir.

Como o caminho das pedras está descrito acima, convido o leitor interessado (disposto e com paciência) a repetir a atividade que eu fiz com o ranking para os BRICS. Clicando nas descrições das 40 melhor classificadas nesse ranking, coletei os indicadores disponíveis e busquei as correlações entre eles, tentando entender as respostas das universidades a seus desafios. Alguns resultados são interessantes, mas isso fica para a próxima coluna.