Na semana passada participei do Encontro Brasileiro de Bibliometria e Cientometria na UFRJ. Foi a sexta edição do evento, sinalizando a consolidação de uma comunidade científica voltada aos indicadores de produção e impacto científicos, atividade que se desdobra continuamente em novas dimensões de análise como a do tema central desse encontro: ciência em rede. Devo abordar aos poucos neste espaço alguns assuntos que chamaram a atenção nas apresentações e discussões de trabalhos por lá. Começo pelo trabalho que eu apresentei, motivado não pela autopromoção, mas por uma coincidência, pois na volta deparei-me com uma manchete no portal UOL que se relaciona com esse meu trabalho, ambos associados a rankings, tanto de países, quanto de universidades.

Na semana passada participei do Encontro Brasileiro de Bibliometria e Cientometria na UFRJ. Foi a sexta edição do evento, sinalizando a consolidação de uma comunidade científica voltada aos indicadores de produção e impacto científicos, atividade que se desdobra continuamente em novas dimensões de análise como a do tema central desse encontro: ciência em rede. Devo abordar aos poucos neste espaço alguns assuntos que chamaram a atenção nas apresentações e discussões de trabalhos por lá. Começo pelo trabalho que eu apresentei, motivado não pela autopromoção, mas por uma coincidência, pois na volta deparei-me com uma manchete no portal UOL que se relaciona com esse meu trabalho, ambos associados a rankings, tanto de países, quanto de universidades.

O título da minha apresentação oral foi “Impacto de uma única área de conhecimento sobre os indicadores de um país”, resultado de um projeto de iniciação científica de Fábio Vinco e Silva. No caso, a área do conhecimento é a Astronomia e o país é o Chile. A origem remota do trabalho, foi, por um lado, um ranking e, por outro, a maneira como foi divulgado pela nossa imprensa. Ambos questionáveis. O ranking é o Nature Index Global (2014) com o seu Global Overview [I], em que o Chile é apresentado como destaque quanto à sua “eficiência financeira” (fração ponderada dos artigos publicados em um conjunto de 68 periódicos de alto impacto dividido pelo gasto em Ciência e Tecnologia do país). A divulgação na imprensa na época destaca que “gasto brasileiro com ciência é muito pouco eficiente [II]. É um discurso que alimenta a narrativa da alegada ineficiência da nossa ciência, sem buscar entender a fonte dos dados, como por exemplo de que a liderança nesse ranking de eficiência coube à Arábia Saudita. O trabalho do Fábio deixou o país do Oriente Médio de lado e focou o Chile, mais próximo, 12º nesse ranking (Brasil era o 50º em 53 países avaliados). O que ocorre é que o Chile apresenta um perfil de produção científica único, no qual 10% dos artigos com pelo menos um autor de uma instituição de pesquisa chilena são na área de Astronomia e Astrofísica. Em outros países líderes nessa área em termos absolutos, essa parcela não ultrapassa os 2% do total. Astronomia e Astrofísica é uma área em que o número médio de citações tende a ser muito alto, comparado com outros domínios. Esse perfil de atividade científica faz com que a média geral de impacto do Chile seja também bastante alto, mas cuidado: números generalizados podem ser falsos positivos. Uma analogia simples é a de um estudante que tira 10 na primeira prova, três na segunda e 2 na terceira, que na média, portanto, é aprovado. Com isso não se pretende dizer que o Chile é mal aluno, evidentemente, mas que tem o privilégio de abrigar os melhores observatórios astronômicos do mundo, que atraem pesquisadores de todas as partes, e soube construir uma boa escola nessa ciência.

O desafio chileno, no entanto, é exatamente diversificar seu perfil de pesquisa [III]. Esse é o contexto, mas o “ranking” da Nature contabiliza artigos publicados naquele conjunto de 68 periódicos de alto impacto, que incluem justa e coincidentemente – pelas características da área – várias revistas de Astronomia e Astrofísica. O interesse central do trabalho do Fábio é entender a dinâmica de pesquisa de um desses conjuntos de observatórios, o principal deles, chamado de European Southern Observatory, que sozinho é responsável por 4,1% de toda a produção científica do país, com uma média de citações por artigo 4 vezes maior do que o resto, é a prova com nota 10. O nosso trabalho sobre isso deverá estar disponível em breve nos anais do 6º EBBC. O tema aqui e agora é outro.

Os levantamentos da Nature nos anos seguintes foram melhorados, chamando a atenção para essas distorções próprias de médias gerais, que, no entanto, tanto continuam a chamar a atenção dos “bibliometristas leigos” (que incluem jornalistas) e que já mencionei em coluna passada [IV], advertindo que a ciência é mais do que a soma de seus indicadores. Rankings induzem comparações, mas é preciso estar atento de que essas comparações são entre países (ou instituições) em contextos e com histórias e papeis diferentes. Meras listas sem a compreensão aprofundada de cada item listado perdem suas relevâncias (e alimentam fetiches).

A manchete de sábado passado dizia que “impacto das universidades brasileiras é baixo mesmo na América Latina” [V]. Fui ler porque fiquei curioso para ver se se tratava ou não de bibliometria leiga reverberando a mesma narrativa de eficiência que lamentei acima. O ranking em questão é o da Times Higher Education (THE) [VI] para a América Latina, em que a Unicamp aparece pelo segundo ano consecutivo na liderança. O artigo anunciado pela manchete, no entanto, chama a atenção para um dos parâmetros que compõem o ranking: a influência (impacto dos artigos das universidades listadas medido por citações). Os outros indicadores são ensino, pesquisa (volume de produção, reputação e financiamento), internacionalização e relação com a indústria. O impacto (influência) corresponde a 20% da nota e, segundo o artigo, “o Brasil vai bem na maioria dos quesitos, mas derrapa no impacto de seus trabalhos acadêmicos”. O artigo também chama a atenção de que na listagem mundial o impacto vale ainda mais, ou seja, 30%. Eu veria de outra forma: talvez os proponentes das listagens tenham entendido de que o papel das universidades na América Latina seria diferente do que na América do Norte ou Europa. Novamente: cada universidade desenvolve-se em um contexto, tem sua própria história e desempenha um papel diferente, de acordo com a sociedade na qual está inserida. E isso é perfeitamente perceptível, quando não ficamos presos apenas nas posições, mas buscamos mais informações sobre cada universidade na listagem.

O artigo destaca que a Unicamp, líder geral, é apenas a 28ª colocada no quesito impacto, cuja liderança cabe à Universidade Cayetano Heredia, no Peru, seguida da Diego Portales, no Chile. Precisamos então conhecer estas universidades, não necessariamente fazer etnografias [VII], mas gastar um pouco de tempo na análise dos chamados dados secundários. Usando a base bibliográfica Scopus (que é a utilizada para a confecção dos rankings da THE) o Peru apresenta no total 24.702 documentos [VIII] e a Universidade Cayetano Heredia alcança 4.088 documentos, sendo 3.092 classificados na área de Medicina, ou seja, uma forte concentração em apenas uma das áreas do conhecimento. Nas edições anteriores do mesmo ranking ela nem aparece, talvez pelo fato de que a concentração em poucas áreas é um critério de exclusão e sua diversificação (ainda com uma produção incipiente) em outras áreas seja muito recente. É bom lembrar que a cultura de citações nessa área apresenta índices altos (como na Astronomia e Astrofísica), comparados com diversas outras áreas. O portal Web of Science, aponta números um pouco diferentes: o total de documentos da Cayetano Heredia é de 4.482 e as principais subcategorias são: saúde pública (1.012 docs), medicina tropical (803), doenças infecciosas (705), seguidos de imunologia (356) e microbiologia (302), que no conjunto receberam 16,16 citações por documento. É possível comparar com a Unicamp, por exemplo? O acervo brasileiro é de 850 mil documentos e a Unicamp soma mais de 65 mil (quase três vezes a produção de todo o Peru). Considerando apenas os documentos nas principais categorias da universidade peruana (que não são as da Unicamp, ativa em muito mais áreas), a média de citações de fato é de apenas 11,35. Mas a média de citações de saúde pública é bem diferente da de imunologia, por exemplo. Faz algum sentido a compilação que eu fiz? Comparar as principais subáreas de uma universidade com as correspondentes em outra? Outro exemplo: para os documentos em Bioquímica e Biologia Molecular, a média de citações da Unicamp é de 17,6 por documento e a da Cayetano Heredia é de 12,5. Posições invertidas.

A segunda maior nota em impacto no ranking em questão é a da Diego Portales, do Chile, que é menor do que a Cayetano Heredia, apenas 2.952 documentos na base Scopus, mas com um perfil bem mais abrangente e distribuído entre as áreas. Pela Web of Science (base na qual a busca de indicadores de citações é mais acessível) são 2.462 documentos com 8,21 citações por documento (geral para todas as áreas). E agora? O segundo colocado tem uma média geral que é apenas a metade do primeiro colocado? Mas atenção: no ranking há uma ponderação por área nas médias. Qual é a principal categoria da universidade chilena, a que teria maior peso na média? Volto a lembrar meu trabalho apresentado no encontro carioca, pois 341 documentos são justamente em Astronomia e Astrofísica, 14% do total. A segunda categoria é arquitetura, com apenas 133 documentos, pouco mais de 5%. A média de citações em Astronomia para essa universidade é de 11,23 e em Arquitetura meros 0,11, o que é assim mesmo nesse campo. Mas isso ainda não explica a discrepância e entendê-la aponta as limitações no rápido levantamento que eu fiz até agora. Mas modificar a análise, quando encontramos resultados estranhos, faz parte, da ciência e do jornalismo.

Os números que eu coletei até aqui referem-se a (tanto do número de artigos/documentos, quanto de citações) todo o intervalo de anos coberto pelos portais, seja o Scopus ou Web of Science. É necessário, portanto, examinar melhor a metodologia usada pela THE, e lá encontramos que o ranking de 2018 levou em conta as publicações entre 2012 e 2016 e as citações a esses artigos entre 2012 e 2107. Assim, as ponderações acima não são as mais adequadas (levei em conta todos os anos), mas corrijo agora para esse caso, fazendo o ajuste temporal necessário, só que pelo Web of Science, devido as razões já apontadas (facilidade para encontrar o número de citações). No período 2012-2016 encontramos 1.247 documentos pela Diego Portales, que receberam pouco mais de 13 mil citações, estabelecendo uma média de 11 citações por documento. Dessas citações, 5.341 são para apenas seis artigos publicados na Lancet sobre um panorama global de diferentes aspectos de saúde. O mais citado tem até agora 2.244 citações, mas não consegui contar o número de autores pertencentes a 496 instituições diferentes que assinam o artigo. Algo parecido ocorre com os outros cinco documentos. No ranking de 2016 a Diego Portales apresenta um score de 62,4 para o impacto, que sobre para 99,9 em 2018. Por quê? Na metodologia utilizada em 2016 foram excluídos esses artigos de “hiperautoria”, que voltaram a ser parcialmente considerados em 2017 e 2018. Seriam esses “outliers” que jogam o placar para cima? Provavelmente, sim. Mais um cuidado na interpretação dos rankings: a medalha de prata em impacto é devido a uma meia dúzia de artigos de coautoria envolvendo centenas de instituições. Diz pouco sobre a pesquisa institucionalizada como um todo na universidade.

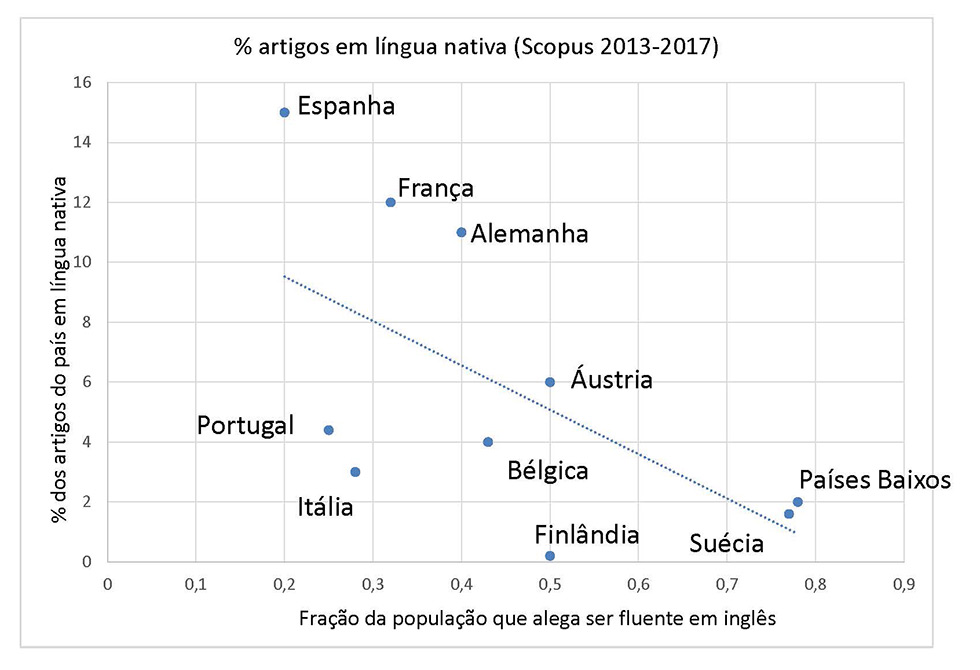

E os exemplos poderiam se avolumar, pois cada universidade tem a sua história. O artigo, cuja manchete me incomodou, aponta então algumas “causas” para o “baixo” impacto. A primeira é de que “o Brasil ainda publica boa parte de seus estudos científicos em português (estima-se que 70% dos mais de 300 periódicos científicos nacionais sejam em língua portuguesa)”. O argumento se refere à necessidade de publicar em inglês para dar maior visibilidade ao trabalho e assim conseguir que despertem interesse e, por fim, terminem por ser citados. Apesar da especulação sobre o uso Português nos periódicos nacionais, o ranking THE se baseia nos artigos indexados na Scopus e não na prática editorial brasileira. E quais são esses números? Das publicações brasileiras entre 2012 e 2016, 15,8% dos artigos são em português. Para a Unicamp essa fração cai para 10,7%. Olhar os dados com atenção sugere que parece não haver incompatibilidade entre termos periódicos em português e o que é considerado pelo ranking da THE. Mas a escolha da língua tem outras implicações. A visibilidade pretendida pelo uso do inglês é para as comunidades científicas espalhadas no mundo e que compartilhem a língua franca da ciência, portanto visando o impacto entre pares. Importante sem dúvida, mas e os outros impactos, na sociedade e na economia? No nosso caso, o português parece ganhar relevância e um pequeno exemplo já foi abordado anteriormente nesse espaço [IX]; assim me aventuro a uma outra pergunta. O que acontece com os outros países não anglófonos? Lembrando de uma edição especial da Science sobre linguagem, que discutia o uso do inglês em outros países, comparo as frações da população que alega ser fluente em Inglês de países da comunidade europeia com as respectivas frações de artigos publicados na língua nacional desses países (base Scopus). É o gráfico abaixo:

O gráfico, que embute muitas variáveis (tamanho da população, falantes da língua em outros países, mercado editorial, perfil de produção científica e a cultura de cada país), parece dizer alguma coisa. Eu diria que a publicação na língua local pode ser importante para a aplicação da ciência em cada país, levando em conta o letramento da população em outra língua. No Brasil parece que 0,3% da população é fluente em inglês. Talvez devêssemos, portanto, publicar mais em português, mas isso é tema para o futuro. Reafirmo que publicar em inglês é importante, mas não pode ser incompatível com a publicação na língua nativa, necessário para a difusão e aplicação local do conhecimento. Sem falar nos ganhos na percepção pública das universidades.

Outra possível “causa” lembrada é a hipótese daqueles que dizem que “o problema (talvez) esteja na qualidade dos trabalhos acadêmicos brasileiros mesmo. Se um estudo científico não trouxer uma descoberta relevante, então dificilmente será citado por trabalhos feitos posteriormente”. Quem compartilha dessa tese precisa primeiro pensar na diferença conceitual entre qualidade e descoberta relevante [X]. Além dos problemas de conceito, não podemos nos esquecer de que a produção científica brasileira está fortemente vinculada a um programa de Estado de pós-graduação, que cresceu (e agora tenta resistir) por décadas. A produção científica que é levada em conta nessas bases de dados usadas pelos rankings era insignificante (em números) antes do primeiro plano nacional de pós-graduação na década de 1970 (pelo menos em Física [XI]). Portanto a produção científica brasileira precisa ser vista também a partir de seu papel formativo de recursos humanos no nível de pós-graduação strictu sensu, que tem uma dimensão sem paralelo na América Latina. Um ônus e um bônus.

Finalmente, o artigo aponta a necessidade de investimento, mas a irresponsabilidade dos cortes massivos em educação e ciência não se faz sentir imediatamente nos rankings; os efeitos nefastos são de longo prazo. O ranking de 2018 da THE não captura ainda o efeito da queda de financiamento de 2014 para cá. O caso mais antigo (e doloroso) é o da Uerj, que vem caindo na lista (20ª em 2016 e 25ª em 2018), mas seus “scores” para os indicadores que compõe a metodologia têm melhorado nesses três anos. Rankings são difíceis de entender, principalmente se quisermos que digam o que talvez não possam. O que fica claro é antes de pensar no impacto, é preciso fazer pesquisa bem-feita e com rigor para evitar a “generalidade e o reducionismo”, como já disse Alcir Pécora em outro contexto. Vale para ciência, vale para o jornalismo.

[I] https://www.nature.com/articles/515S56a

[III] https://www.nature.com/articles/d41586-017-08385-0

[V] O leitor encontrara a matéria fazendo uma consulta ao Google com o título entre aspas.

[VI] https://www.timeshighereducation.com/world-university-rankings

[VII] https://www.unicamp.br/unicamp/ju/artigos/peter-schulz/por-uma-etnografia-das-universidades

[VIII] Esse e outros dados foram coletados em 23/07/2018

[IX] https://www.unicamp.br/unicamp/ju/artigos/peter-schulz/o-eucalipto-e-seus-impactos

[X] Sobre qualidade versus impacto, vale ler o relato a seguir: https://www.theguardian.com/higher-education-network/2018/jun/15/is-competition-driving-innovation-or-damaging-scientific-research

[XI] http://www.sbfisica.org.br/v1/arquivos_diversos/publicacoes/os-numeros-da-fisica-no-Brasil-hoje.pdf